Planos que suportam este recurso: Professional Business Enterprise

O que é um arquivo Robots.txt?

Um arquivo Robots.txt é um arquivo de texto usado para se comunicar com rastreadores web e outros agentes automatizados sobre quais páginas da sua base de conhecimento não devem ser indexadas. Ele contém regras que especificam quais páginas podem ser acessadas por quais rastreadores.

NOTA

Para mais informações, leia este artigo de ajuda do Google.

Acessando Robots.txt no Document360

Para acessar Robots.txt no Document360:

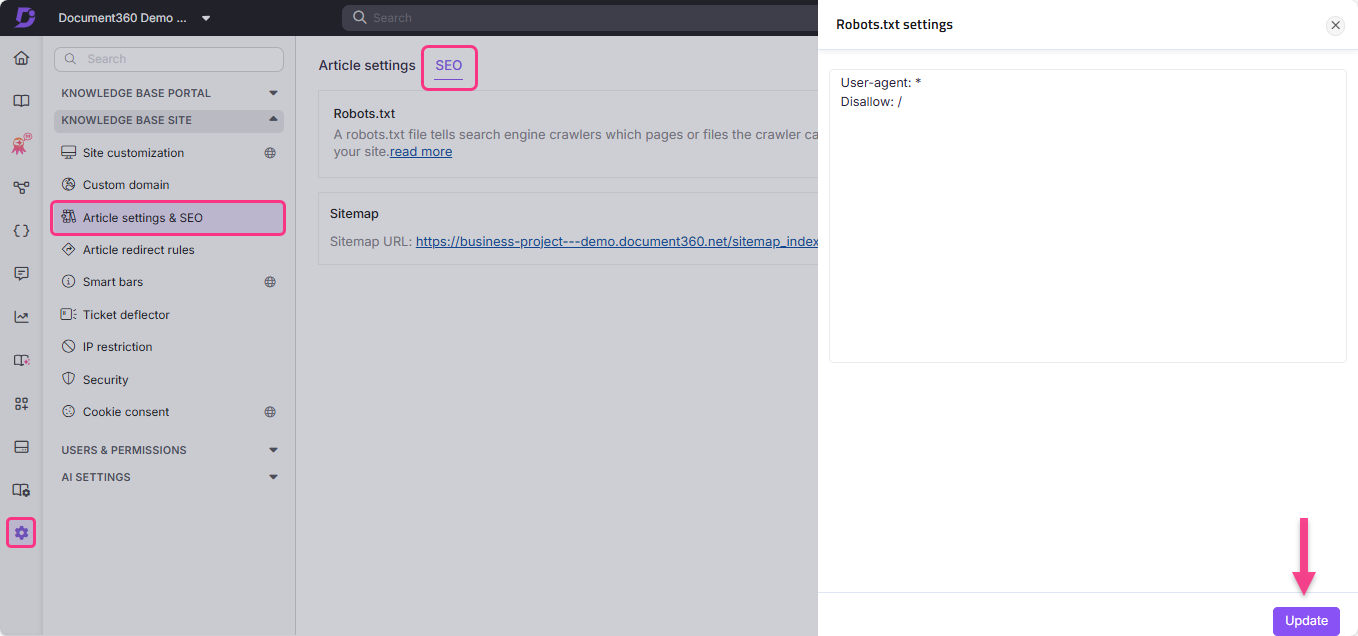

Navegue até Configurações () na barra de navegação da esquerda

Acesse o site da base de conhecimento > Configurações de artigos e SEO > aba SEO .

Localize Robots.txt e clique em Editar.

O painel de configurações Robots.txt vai aparecer.

Digite as regras que quiser.

Clique em Atualizar.

Casos de uso de Robots.txt

Um arquivo Robots.txt pode impedir que uma pasta, um arquivo (como um PDF) ou extensões específicas de arquivo sejam rastreados.

Você também pode atrasar a velocidade de rastreamento dos bots adicionando atraso de rastreamento no seu arquivo Robots.txt. Isso é útil quando seu site está recebendo muito tráfego.

User-agent: *

Crawl-delay: 10Restrição do rastreador por meio de dados administrativos

User-agent: *

Disallow: /admin/

Sitemap: https://example.com/sitemap.xml

User-agent: * - Especifica que qualquer bot pode rastrear pelo site.Disallow: /admin/: - Restringe o rastreador de acessar dados administrativos.Sitemap: https://example.com/sitemap.xml - Fornece acesso a bots para rastrear o sitemap. Isso facilita a rastreabilidade, pois o sitemap contém todas as URLs do site.

Restringindo um mecanismo de busca específico de rastrear

User-agent: Bingbot

Disallow: /

O arquivo Robots.txt acima está definido para impedir o Bingbot.

User-agent: Bingbot - Especifica o rastreador do mecanismo de busca Bing.Disallow: / - Restringe Bingbot de rastrear o site.

Melhores Práticas

Inclua links para as páginas mais importantes.

Bloqueie links para páginas que não agregam valor.

Adicione a localização do sitemap no arquivo Robots.txt .

Um arquivo Robots.txt não pode ser adicionado duas vezes. Por favor, consulte as diretrizes básicas da documentação do Google Search Central para mais informações.

NOTA

Um rastreador de web, também conhecido como Spider ou Spiderbot, é um programa ou script que navega automaticamente pela web e coleta informações sobre vários sites. Mecanismos de busca como Google, Bing e Yandex usam rastreadores para replicar as informações de um site em seus servidores.

Rastreadores abrem novas abas e rolam pelo conteúdo do site, assim como um usuário visualizando uma página web. Além disso, crawlers coletam dados ou metadados do site e de outras entidades (como links em uma página, links quebrados, sitemaps e código HTML) e enviam para os servidores de seus respectivos mecanismos de busca. Os mecanismos de busca usam essas informações registradas para indexar resultados de forma eficaz.

Perguntas frequentes

Como faço para remover meu projeto Document360 do índice de busca do Google?

Para excluir todo o projeto do índice de busca do Google:

Navegue até Configurações () na barra de navegação à esquerda do Portal da base de conhecimento.

No painel de navegação à esquerda, navegue até o site da base de conhecimento > Configurações de artigo e SEO > aba SEO .

Vá até a aba SEO e clique em Editar no

Robots.txtarquivo .Cole o seguinte código:

User-Agent: Googlebot

Disallow: Clique em Atualizar.

Como faço para evitar que páginas de tag sejam indexadas pelos mecanismos de busca?

Para excluir as páginas de tag dos mecanismos de busca:

Navegue até Configurações () na barra de navegação da esquerda.

Acesse o site da base de conhecimento > Configurações de artigos e SEO > aba SEO .

Clique em Editar no

Robots.txtarquivo .Cole o seguinte código:

User-agent: *

Disallow: /docs/en/tags/Clique em Atualizar.