Pläne, die diese Funktion unterstützen: Professional Business Enterprise

Was ist eine Robots.txt-Akte?

Eine Robots.txt-Datei ist eine Textdatei, die verwendet wird, um mit Webcrawlern und anderen automatisierten Agenten darüber zu kommunizieren, welche Seiten Ihrer Wissensdatenbank nicht indexiert werden sollten. Sie enthält Regeln, die festlegen, welche Seiten von welchen Crawlern abgerufen werden dürfen.

HINWEIS

Für weitere Informationen lesen Sie bitte diesen Hilfeartikel von Google.

Zugriff auf Robots.txt in Document360

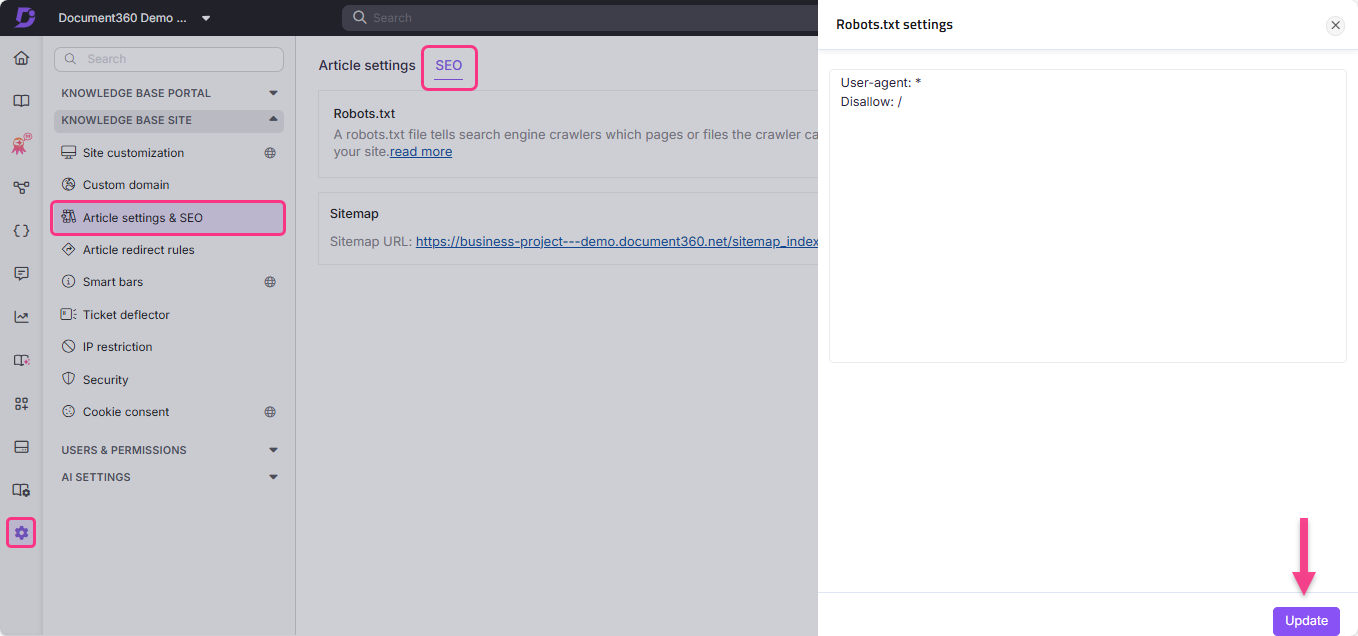

Um Robots.txt in Document360 abzurufen:

Navigiere in der linken Navigationsleiste zu Einstellungen ()

Gehen Sie zur Knowledge Base-Seite > Artikeleinstellungen & SEO > SEO-Reiter .

Finde Robots.txt und klicke auf Bearbeiten.

Das Einstellungsfeld Robots.txt erscheint.

Gib deine gewünschten Regeln ein.

Klicken Sie auf Aktualisieren.

Anwendungsfälle von Robots.txt

Eine Robots.txt-Datei kann einen Ordner, eine Datei (wie ein PDF) oder bestimmte Dateiendungen daran hindern, gecrawlt zu werden.

Du kannst auch die Crawl-Geschwindigkeit von Bots verzögern, indem du Crawl-Delay in deine Robots.txt-Datei einfügst. Das ist nützlich, wenn Ihre Seite viel Traffic verzeichnet.

User-agent: *

Crawl-delay: 10Einschränkung des Crawlers über Administratordaten

User-agent: *

Disallow: /admin/

Sitemap: https://example.com/sitemap.xml

User-agent: * - Spezifiziert, dass jeder Bot durch die Seite crawlen kann.Disallow: /admin/: - Begrenzt den Zugriff auf Administratordaten.Sitemap: https://example.com/sitemap.xml - Bietet Zugang zu Bots, um die Sitemap zu crawlen. Das erleichtert das Crawlen, da die Sitemap alle URLs der Seite enthält.

Einschränkung einer bestimmten Suchmaschine beim Crawlen

User-agent: Bingbot

Disallow: /

Die obige Robots.txt Datei ist so definiert, dass sie den Bingbot nicht erlaubt.

User-agent: Bingbot - Spezifiziert den Crawler aus der Bing-Suchmaschine.Disallow: / - Beschränkt Bingbot darauf, die Seite zu crawlen.

Best Practices

Fügen Sie Links zu den wichtigsten Seiten hinzu.

Blockiere Links zu Seiten, die keinen Wert bieten.

Fügen Sie den Sitemap-Standort in die Robots.txt-Datei ein.

Eine Robots.txt-Datei kann nicht zweimal hinzugefügt werden. Bitte lesen Sie die grundlegenden Richtlinien in der Google Search Central-Dokumentation für weitere Informationen.

HINWEIS

Ein Webcrawler, auch bekannt als Spider oder Spiderbot, ist ein Programm oder Skript, das automatisch im Web navigiert und Informationen über verschiedene Websites sammelt. Suchmaschinen wie Google, Bing und Yandex nutzen Crawler, um die Informationen einer Seite auf ihren Servern zu replizieren.

Crawler öffnen neue Tabs und scrollen durch Website-Inhalte, genau wie ein Nutzer, der eine Webseite betrachtet. Zusätzlich sammeln Crawler Daten oder Metadaten von der Website und anderen Entitäten (wie Links auf einer Seite, defekte Links, Sitemaps und HTML-Code) und senden sie an die Server ihrer jeweiligen Suchmaschine. Suchmaschinen nutzen diese aufgezeichneten Informationen, um Suchergebnisse effektiv zu indexieren.

FAQs

Wie entferne ich mein Document360-Projekt aus dem Google-Suchindex?

Um das gesamte Projekt aus dem Google-Suchindex auszuschließen:

Navigiere zu Einstellungen () in der linken Navigationsleiste im Knowledge base portal.

Im linken Navigationsbereich navigieren Sie zur Wissensdatenbank > Artikeleinstellungen & SEO > SEO-Reiter .

Gehe zum SEO-Tab und klicke auf Bearbeiten in der

Robots.txt.Fügen Sie folgenden Code ein:

User-Agent: Googlebot

Disallow: Klicken Sie auf Aktualisieren.

Wie kann ich verhindern, dass Tag-Seiten von Suchmaschinen indexiert werden?

Um die Tag-Seiten aus den Suchmaschinen auszuschließen:

Navigiere in der linken Navigationsleiste zu Einstellungen () ().

Gehen Sie zur Knowledge Base-Seite > Artikeleinstellungen & SEO > SEO-Reiter .

Klicken Sie auf Bearbeiten in der

Robots.txt.Fügen Sie folgenden Code ein:

User-agent: *

Disallow: /docs/en/tags/Klicken Sie auf Aktualisieren.