Planes que admiten esta función: Professional Business Enterprise

¿Qué es un archivo Robots.txt?

Un archivo Robots.txt es un archivo de texto utilizado para comunicarse con rastreadores web y otros agentes automatizados sobre qué páginas de tu base de conocimiento no deben estar indexadas. Contiene reglas que especifican qué páginas pueden ser accedidas por qué rastreadores.

NOTA

Para más información, lee este artículo de ayuda de Google.

Acceso a Robots.txt en Document360

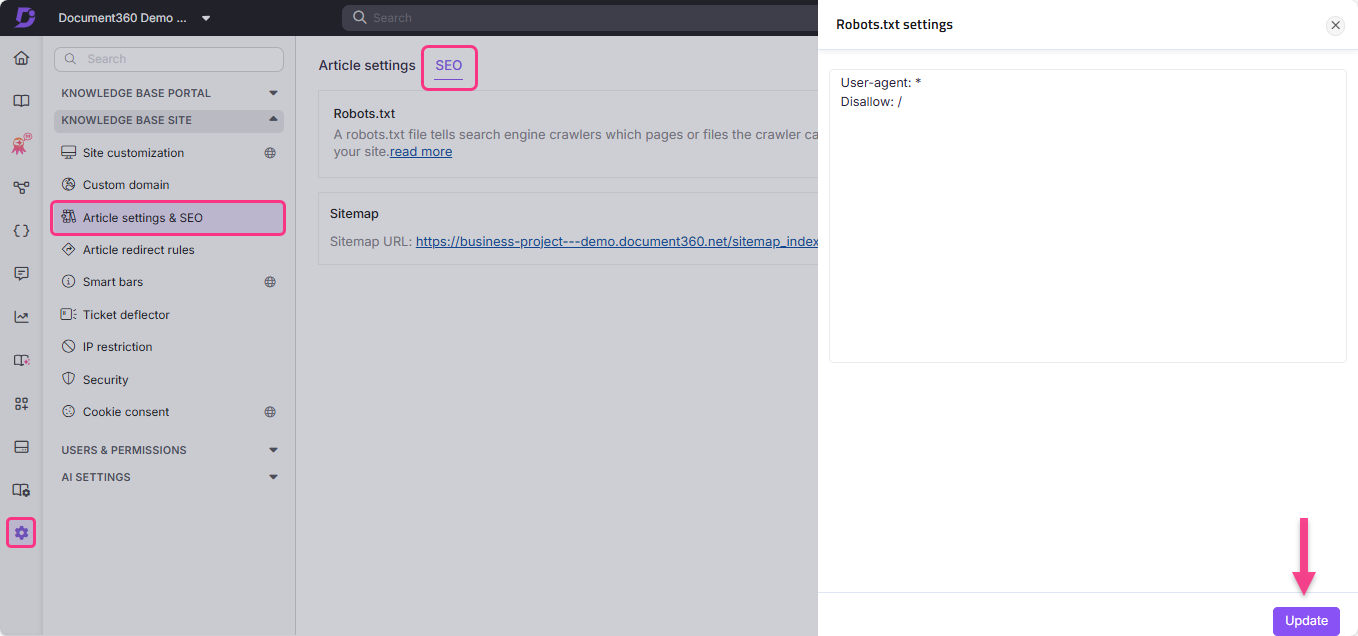

Para acceder a Robots.txt en Document360:

Navega a Configuración () en la barra de navegación izquierda

Ve a la página de la base de conocimientos > Configuración de artículos y SEO > pestaña SEO .

Localiza Robots.txt y haz clic en Editar.

Aparecerá el panel de configuración de Robots.txt .

Escribe las reglas que quieras.

Haz clic en Actualizar.

Casos de uso de Robots.txt

Un archivo Robots.txt puede bloquear una carpeta, un archivo (como un PDF) o extensiones específicas de archivo para que no se rastreen.

También puedes retrasar la velocidad de rastreo de los bots añadiendo el rastreo en tu archivo de Robots.txt. Esto es útil cuando tu sitio está experimentando mucho tráfico.

User-agent: *

Crawl-delay: 10Restringir el rastreador mediante datos de administrador

User-agent: *

Disallow: /admin/

Sitemap: https://example.com/sitemap.xml

User-agent: * - Especifica que cualquier bot puede rastrear el sitio.Disallow: /admin/: - Restringe el acceso al rastreador a los datos de administrador.Sitemap: https://example.com/sitemap.xml - Proporciona acceso a bots para rastrear el sitemap. Esto facilita el rastreo ya que el sitemap contiene todas las URLs del sitio.

Restringir el rastreo de un motor de búsqueda específico

User-agent: Bingbot

Disallow: /

El archivo Robots.txt anterior está definido para prohibir el Bingbot.

User-agent: Bingbot - Especifica el rastreador del motor de búsqueda Bing.Disallow: / - Restringe a Bingbot rastrear el sitio.

Mejores prácticas

Incluye enlaces a las páginas más importantes.

Bloquea enlaces a páginas que no aportan ningún valor.

Añade la ubicación del sitemap en el archivo Robots.txt .

Un archivo Robots.txt no se puede añadir dos veces. Por favor, consulte las directrices básicas de la documentación de Google Search Central para más información.

NOTA

Un rastreador web, también conocido como Spider o Spiderbot, es un programa o script que navega automáticamente por la web y recopila información sobre diversos sitios web. Motores de búsqueda como Google, Bing y Yandex utilizan rastreadores para replicar la información de un sitio en sus servidores.

Los rastreadores abren nuevas pestañas y se desplazan por el contenido del sitio web, igual que un usuario que ve una página web. Además, los rastreadores recopilan datos o metadatos del sitio web y de otras entidades (como enlaces en una página, enlaces rotos, mapas de sitio y código HTML) y los envían a los servidores de sus respectivos motores de búsqueda. Los motores de búsqueda utilizan esta información registrada para indexar resultados de forma eficaz.

Preguntas frecuentes

¿Cómo puedo eliminar mi proyecto de Document360 del índice de búsqueda de Google?

Para excluir todo el proyecto del índice de búsqueda de Google:

Navega a Configuración () en la barra de navegación izquierda del Portal de la base de conocimientos.

En el panel de navegación izquierdo, navega a la pestaña de Configuración de artículos >> SEO de la base de conocimientos.

Ve a la pestaña SEO y haz clic en Editar en el

Robots.txtarchivo .Pega el siguiente código:

User-Agent: Googlebot

Disallow: Haz clic en Actualizar.

¿Cómo evito que los motores de búsqueda indexen las páginas de etiquetas?

Para excluir las páginas de etiquetas de los motores de búsqueda:

Navega a Configuración () en la barra de navegación izquierda.

Ve a la página de la base de conocimientos > Configuración de artículos y SEO > pestaña SEO .

Haz clic en Editar en el

Robots.txtarchivo .Pega el siguiente código:

User-agent: *

Disallow: /docs/en/tags/Haz clic en Actualizar.